авторка Оксана Полулях

Сьогодні практично кожна людина має доступ до інструментів штучного інтелекту (ШІ), здатних створювати зображення, що виглядають реалістично – принаймні на перший погляд. Однак ці технології стають потужним інструментом в руках тих, хто прагне маніпулювати суспільною думкою. Росія активно використовує ШІ у своїй інформаційній війні. Як саме працюють ШІ-фальшивки, чому вони особливо небезпечні під час війни та як їх розпізнати – у цьому тексті.

Чи здатні ми розпізнати ШІ-згенеровані зображення?

Згідно з дослідженням Чиказького університету, лише 60% інтернет-користувачів можуть визначити, чи зображення створене за допомогою ШІ. Це викликає занепокоєння, враховуючи постійне вдосконалення таких технологій. Українці також не є винятком. Опитування Kantar Україна (лютий 2024 року) показало, що 79% респондентів знають, що таке ШІ, але лише 42% впевнені у своїх навичках розпізнавати подібний контент.

Невміння відрізнити реальне від згенерованого має важливі наслідки: від порушення авторських прав до ризиків дезінформації та шахрайства.

Чому згенерований ШІ контент може бути небезпечним?

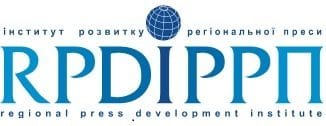

ШІ-зображення часто використовуються для маніпулювання емоціями. Ви певне зустрічали у своїй Facebook-стрічці зображення нібито військових із проханням підтримати їх у важливі моменти – день народження чи весілля. Що вам шкода вподобайки для військового, який тільки що одружився? А може все ж варто підтримати коментарем юнака, якого ніхто з рідних не привітав з днем народження?

Колаж – StopFake

Такі публікації збирають тисячі вподобань та коментарів, підвищуючи охоплення сторінок. Проте за їхньою емоційністю можуть ховатися зловмисні наміри: сторінки змінюють тематику або використовуються для поширення пропаганди.

Українські соцмережі не єдині, які стикаються із проблемою поширення ШІ-згенерованого контенту. Американський Facebook також заполонили подібні зображення: людей похилого віку, осіб з ампутованими кінцівками та немовлят. Такі публікації часто супроводжуються емоційними підписами на кшталт «Ніхто ніколи не благословляв мене» або «Зробив це власноруч. Буду радий вашим оцінкам». У серпні 2024 року Рене ДіРеста зі Стенфордського університету та Джош Голдштейн із Центру безпеки й нових технологій Джорджтаунського університету опублікували дослідження, яке показало, що ШІ-згенеровані зображення активно використовуються шахраями й спамерами. Такі зображення сприяють швидкому зростанню аудиторії сторінок і підвищують активність користувачів, що дозволяє згодом монетизувати їхню популярність. Як наслідок, ці сторінки часто змінюють назви та починають поширювати зовсім інший контент, іноді шахрайського характеру.

Окрім змін назв сторінок, шахраї маніпулюють і змістом публікацій. Наприклад, учора ви могли поділитися зображенням військового, який закликає молитися за перемогу, а сьогодні виявити, що на його місці зовсім інший пост із протилежним змістом. Така тактика вводить користувачів в оману, створюючи ілюзію широкої підтримки нової публікації, хоча «вподобайки» та «репости» були отримані завдяки іншому контенту. StopFake досліджував подібний випадок: зловмисники відредагували зміст публікації, перетворивши її на фейк, описаний у матеріалі «Фейк: Український пілот викрав літак і «втік в Африку до коханої».

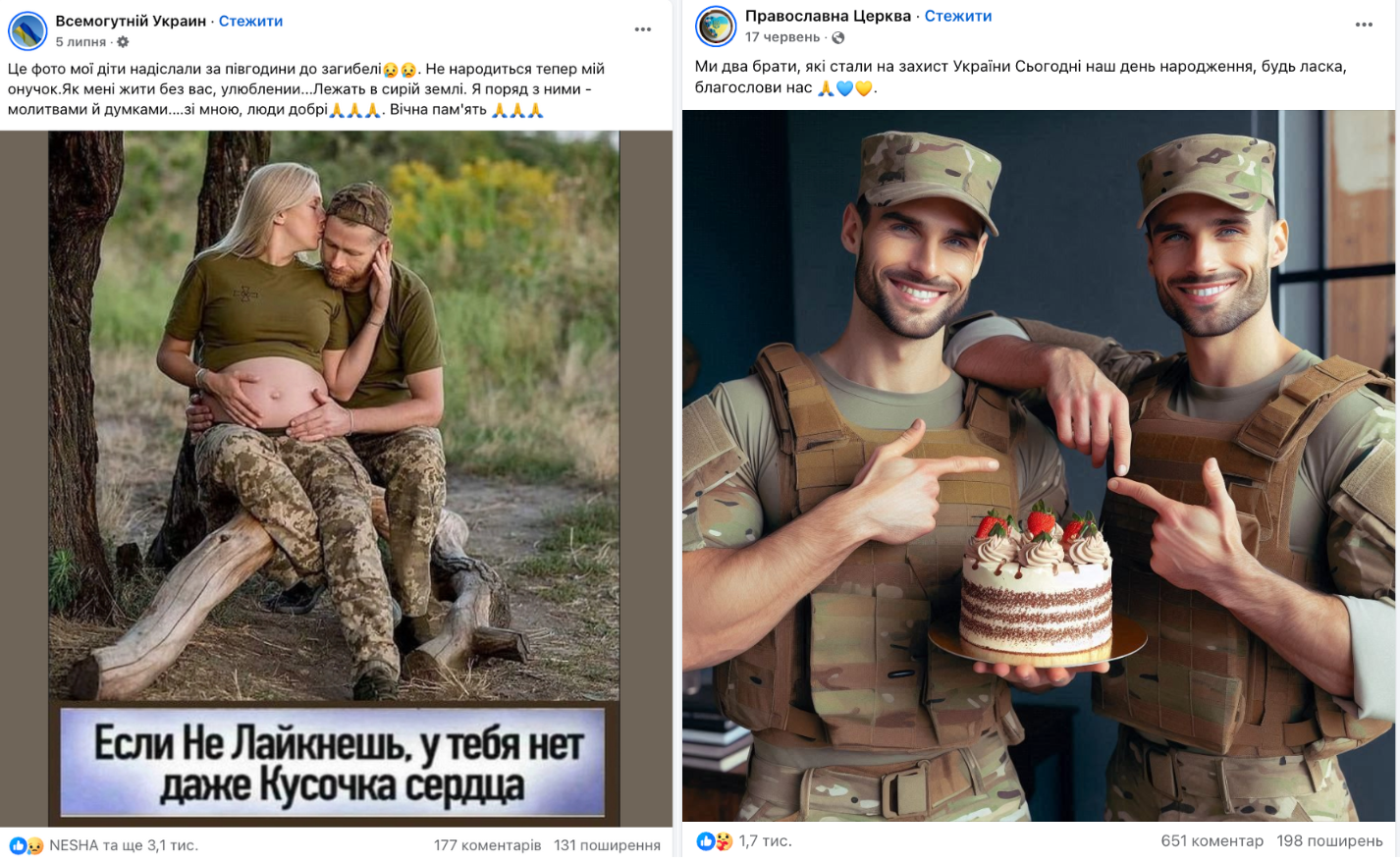

Аналітики Інституту масової інформації виявили, що релігійна організація, заснована в Китаї, використовує ШІ-згенеровані зображення для залучення українців до своїх лав. Під емоційними фотографіями українських військових чи літніх людей користувачі ставлять вподобайки, містяться запрошення до закритих груп у WhatsApp для спільних молитов. Однак на цих онлайн-молитвах, замість обіцяних молитов за українських воїнів, поширюються наративи, що толерують прославлення країни-агресора Росії. Експерти ІМІ підкреслюють, що такі методи спрямовані на вразливих людей, зокрема тих, у чиїх сім’ях є військові. Ці люди часто переживають за перебіг війни й шукають підтримки.

Скриншот – ІМІ

В умовах війни подібні дії виглядають особливо загрозливими. У Центрі протидії дезінформації при РНБО зазначають, що сторінки зі ШІ-згенерованими зображеннями збирають велику аудиторію, яка недостатньо критично ставиться до інформації у мережі та сприйнятлива до інформаційних маніпуляцій. У такий спосіб ворог отримує майданчик для просування небезпечних для України наративів.

У жовтні 2024 року корпорація Microsoft оприлюднила звіт про кіберзагрози, що охоплює період з липня 2023 по червень 2024 року. Згідно зі звітом, країни на кшталт Росії, Ірану та Китаю все активніше використовують ШІ для підвищення охоплення, ефективності й залучення у своїх інформаційних кампаніях. Навіть розробники ШІ-інструментів визнають: їхні інструменти, як ChatGPT, неконтрольовано використовуються Росією для маніпулювання громадською думкою по всьому світу.

Одним із найбільш помітних прикладів інформаційної атаки Росії проти України став шквал ШІ-згенерованих зображень українських військових, що поширювався наприкінці 2023 року. Ці зображення супроводжувалися текстами про те, що українські військові в Авдіївці Донецької області моляться про порятунок та просять про молитву українців. Зважаючи на складність боїв у цьому регіоні, такі повідомлення мали сильний емоційний вплив.

Однак за спостереженнями StopFake, основними поширювачами цих публікацій були ботоподібні акаунти. Масштаб і швидкість розповсюдження контенту вказують на те, що ця кампанія була ретельно спланованою частиною російської дезінформаційної операції. Її головна мета – посіяти серед українців почуття страху, паніки й зневіри, а також підірвати бойовий дух захисників.

Ця кампанія також демонструє, як ефективно використовуються ШІ-технології для створення ілюзії масштабної підтримки чи паніки. Деякі зображення військових у моменти розпачу виглядали настільки реалістично, що могли збити з пантелику навіть досвідчених користувачів мережі. Окрім підриву морального стану, такі маніпуляції спрямовані на підсилення внутрішніх суперечностей у суспільстві, поширення сумнівів щодо стратегії оборони України й створення образу «втомленої» армії.

Колаж – StopFake

На цій фотографії зображено малюка, який нібито вижив після чергового російського обстрілу Дніпра. Підпис до фото емоційно підкреслює трагедію: «Він завжди запам’ятає, хто зруйнував його світ». Хлопчик стоїть на фоні зруйнованої будівлі, тримаючи в руках, ймовірно, шматочок хліба. Шеврон із прапором на його куртці недвозначно вказує, що він – українець. Попри явні ознаки того, що це зображення є несправжнім, багато користувачів щиро співчували дитині в коментарях, цікавлячись долею його батьків.

Скриншот – facebook.com

Це зображення стало вірусним 14 січня 2023 року, невдовзі після ракетного удару по багатоповерхівці в Дніпрі, який забрав життя 46 людей, серед яких було шестеро дітей, і залишив близько 80 поранених. І навіть офіційні акаунти Верховної Ради України поширили цей контент, що спричинило шквал обурення та критики, адже використання ШІ-згенерованих зображень у подібному контексті лише підриває довіру до реальних фактів.

Подібні ШІ-зображення, що імітують наслідки руйнувань в Україні та страждання цивільного населення, часто стають вірусними. Їх поширюють навіть активніше, ніж реальні фотографії наслідків російських атак. Деякі виправдовують це тим, що такі зображення є лише «ілюстративними», але статистика доводить інше: 40% користувачів не можуть розпізнати ШІ-згенеровані зображення.

Використання таких фото не тільки розмиває реальність, але й спотворює правду про воєнні злочини Росії. Російська пропаганда використовує насичення інформаційного простору подібними матеріалами для формування наративу про те, що жертви серед цивільного населення в Україні – вигадка українських чи західних розвідок. Логіка пропаганди проста: «Якщо українці брешуть про хлопчика з Дніпра, вони можуть обманювати й про інші трагедії».

Про те, як російська дезінформація створює та поширює подібні сумніви, можна дізнатися з матеріалів StopFake: «Фейк: Масові жертви серед мирного населення Київської області – інсценування», «Фейк: Звірства російських військових у Гостомелі – «українське постановне відео», Відеофейк: репортаж про жертви серед цивільного населення в Україні – «постановний».

Такі випадки підкреслюють необхідність критичного мислення й перевірки інформації, адже необережне поширення ШІ-згенерованого контенту ненавмисно грає на руку російській пропаганді.

Як розпізнати ШІ-згенероване зображення?

Виявлення підроблених зображень, створених за допомогою штучного інтелекту, є складним завданням, але можливим. Нижче наведено основні підходи та критерії, які допоможуть визначити, чи є фото реальним або згенерованим ШІ.

1. Перевірка водяних знаків та метаданих

- Водяні знаки. Насамперед перевірте, чи містить зображення водяний знак генератора ШІ (наприклад, MidJourney або DALL-E). Водяний знак часто розташований у куті зображення.

- Опис зображення. Уважно перегляньте підписи до публікації або коментарі – автор може зазначити першоджерело або вказати, що зображення було створено за допомогою ШІ.

- Метадані. Якщо доступні, аналіз метаданих може надати інформацію про дату створення, місцезнаходження, налаштування камери та навіть інструмент, яким було створено зображення. Аналіз метаданих може стати ключовим інструментом для перевірки автентичності зображень. Для цього можна використовувати програми, такі як ExifTool або Exif Pilot, які потрібно встановити на комп’ютер. Ці програми забезпечують детальний аналіз метаданих файлів та підходять для роботи з різними форматами.

Зручним онлайн-інструментом є metadata2go – сервіс, який дозволяє швидко перевірити метадані, завантаживши файл на сайт.

2. Візуальний аналіз зображення

ШІ-згенеровані фото часто мають спотворення або неприродні деталі. Серед основних ознак:

- Фон. Зображення нерідко мають розмитий або нечіткий фон. Предмети позаду основного сюжету можуть бути спотвореними – видовженими, неприродно розміщеними або складеними з декількох частин.

- Освітлення. Аномалії у розподілі світла – неправильне падіння тіней, дивна яскравість або освітлення, що суперечить закону фізики. Наприклад, сонячні промені можуть «забувати» про реалістичне освітлення об’єкта.

- Деталі обличчя та кінцівок. Хоча ШІ майже досконало відтворює обличчя, все ще трапляються помилки:

- Асиметрія обличчя (нерівний розмір очей, неприродне розташування зубів чи вух).

- Зайві пальці, неприродно вигнуті кінцівки чи проблеми із нігтями.

- Дрібні деталі та написи. Часто уніформа, камуфляж чи шеврони на зображеннях створені з помилками – вони можуть бути вигаданими або містити нереалістичні елементи (наприклад, підсумки, пришиті безпосередньо до кітеля). Написи на зображеннях зазвичай складаються з випадкових букв, пропусків або виглядають безглуздо.

- Дублювання та повторення елементів. ШІ часто зображує людей із майже ідентичними обличчями або дублює текстури. Наприклад, стіни, меблі чи інші об’єкти на фоні можуть повторюватися.

- Місце в просторі. Дивіться, як деталі розташовані одна відносно одної. Предмети, такі як окуляри чи прикраси, можуть «зливатися» з обличчям або навпаки, знаходитися на відстані, де вони не мають бути.

- Цифрові артефакти. Зверніть увагу на пікселізацію, дивні кольорові аномалії чи розмиття в областях, де це виглядає нелогічно.

3. Використання спеціалізованих інструментів

Існують детектори штучного інтелекту, які дозволяють перевіряти зображення на предмет їхньої генерації за допомогою ШІ. Ось детальніше про кожен із популярних інструментів:

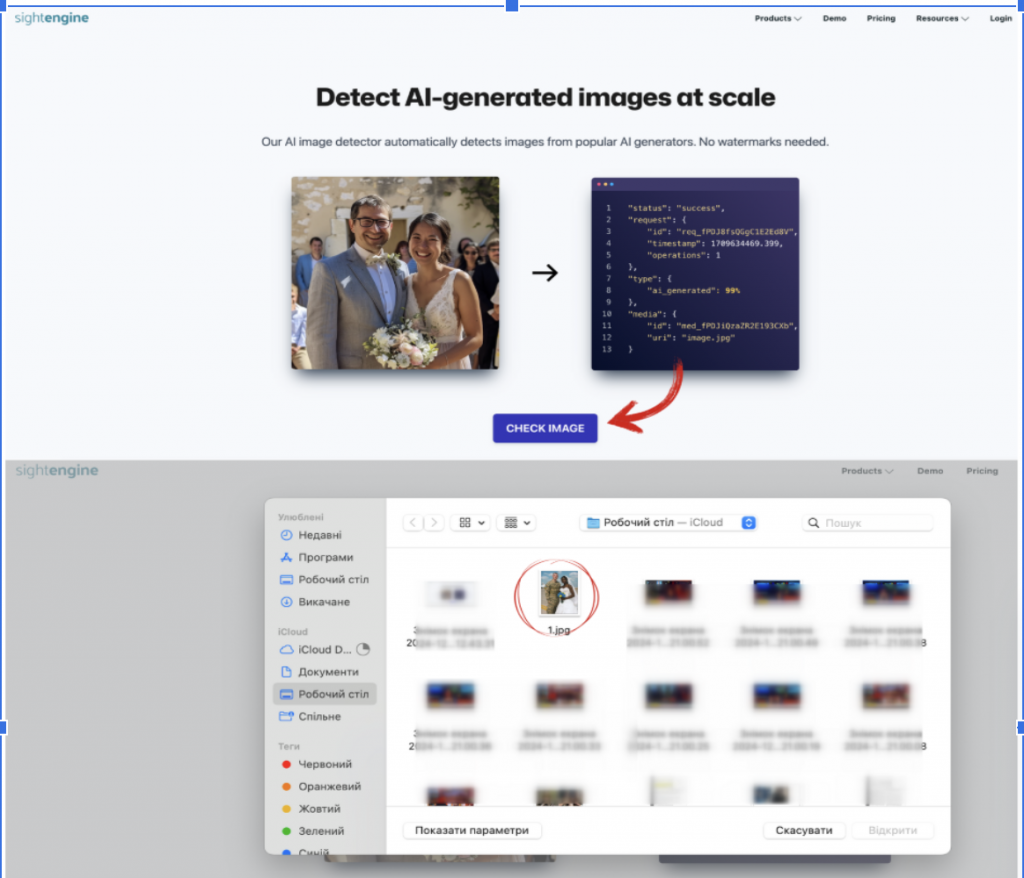

Цей інструмент спеціалізується на аналізі зображень і відео для визначення можливих маніпуляцій або ШІ-генерації. Ви можете завантажити зображення на сайт без реєстрації та отримати швидкий результат. Інструмент зручний для користувачів, які потребують простого і доступного рішення.

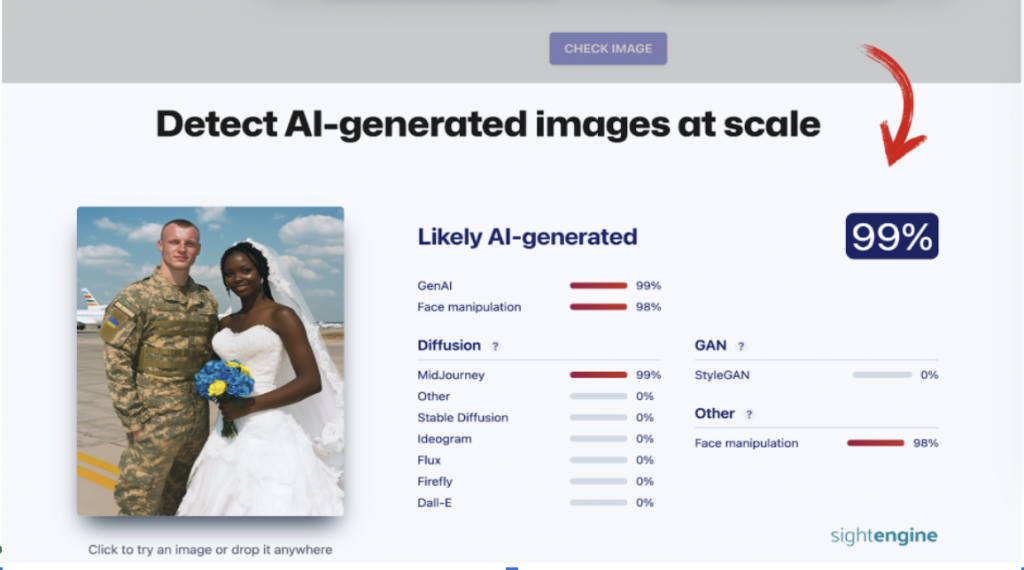

SightEngine – це потужний інструмент, який надає широкий спектр можливостей, включаючи визначення зображень, створених ШІ, перевірку контенту на відповідність стандартам і виявлення маніпуляцій.

Сервіс доступний у безкоштовному режимі з обмеженими функціями. Ви можете перевірити зображення безкоштовно та без реєстрації: достатньо перейти в розділ «Detect AI-generated images at scale», завантажити зображення на сайт і дочекатися результатів. SightEngine здатний визначити ймовірність того, що зображення створене ШІ, а також вказати конкретний генератор (наприклад, MidJourney, DALL-E чи Stable Diffusion).

Цей інструмент працює як онлайн-сервіс і дозволяє швидко визначити, чи було зображення створено штучним інтелектом. Для базового аналізу достатньо скористатися безкоштовною пробною версією, однак для цього необхідно зареєструватися на сайті. Після реєстрації ви можете завантажити зображення, і система надасть результати перевірки, вказуючи ймовірність генерації ШІ. Безкоштовна версія дозволяє перевірити до 10 зображень.

Інструмент ідеально підходить для швидкої перевірки зображень, проте без реєстрації його використання неможливе.

Hive Moderation – це інструмент, який працює на основі API, що підходить для автоматичної перевірки великих обсягів зображень. Водночас сервіс пропонує безкоштовну демоверсію для індивідуальних користувачів. Щоб скористатися нею, необхідно зареєструватися на сайті.

Однак перевірка зображень можлива і без реєстрації. Для цього потрібно перейти в розділ «AI-generated content detection» і обрати функцію «See our AI-Generated Content Detection tools in action». Ви можете завантажити зображення й отримати базові результати перевірки, зокрема інформацію про можливе використання генераторів ШІ.

Скриншот – sightengine.com

Кожен із цих інструментів може бути корисним залежно від ваших потреб – від швидкого аналізу окремих зображень до масштабної перевірки контенту.

Важливо: ці інструменти не завжди дають точний результат, особливо якщо зображення низької якості, тому їх слід використовувати як додатковий, а не основний метод перевірки. Ми також рекомендуємо комбінувати аналіз із іншими способами верифікації для досягнення максимальної достовірності.

4. Інтерактивне навчання

Для вдосконалення навичок розпізнавання ШІ-зображень можна використовувати інтерактивні платформи, такі як тест від The New York Times. Вони дозволяють тренувати уважність і покращувати здатність ідентифікувати підробки.

Штучний інтелект відкриває великі можливості, але водночас створює ризики для інформаційного простору, особливо в умовах війни.

ШІ-згенеровані зображення здатні викликати сильні емоції, вводити в оману та слугувати інструментом для дезінформаційних кампаній ворога.

Важливо пам’ятати: будь-яка взаємодія з підозрілим контентом – вподобайка, коментар чи репост – може грати на руку ворогу: сприяти просуванню пропагандистських наративів, підривати довіру до реальних фактів і навіть може посилювати паніку в суспільстві. Взаємодія з інформацією під час війни вимагає відповідальності. Перевірка фактів та свідоме ставлення до контенту не лише допоможуть захистити себе, а й стануть внеском у стійкість суспільства перед інформаційними загрозами.

Стаття підготовлена за підтримки NDI